Abstract: Der Krieg in der Ukraine gilt als Technikkrieg von historischer Dimension, doch für die ethische Debatte um autonome Waffensysteme und KI hat er bisher keine neuen Argumente hervorgebracht. Allerdings gibt er Anlass zu einer kritischen Bestandsaufnahme der Debatte und ruft die Notwendigkeit internationaler Regulierung in Erinnerung, da das Prinzip der Würde und Verantwortung des Menschen auch durch die Hoffnung, KI könne einmal selbst Moral entwickeln, nicht obsolet wird.

Problemdarstellung: Welche moralischen Lehren sind aus einem Krieg zu ziehen, der als Labor künftiger Kriegsführung gilt?

Was nun?: Die Politik muss die Regulierung von LAWS vorantreiben. Zugleich muss (a) Soldat:innen sowie (b) der Zivilgesellschaft die Bedeutung eines moralisch handelnden Militärs deutlicher werden. Das ist Aufgabe des Militärs (Stärkung von Formaten ethischer Bildung) sowie gesellschaftlicher Institutionen. Wenn sich zivile Bildungseinrichtungen und die Scientific Community dem Thema Krieg und Militär mehr als bisher öffnen und dessen ethischen Rahmen betonen, können sie Sorgen vor einer Militarisierung der Gesellschaft mindern.

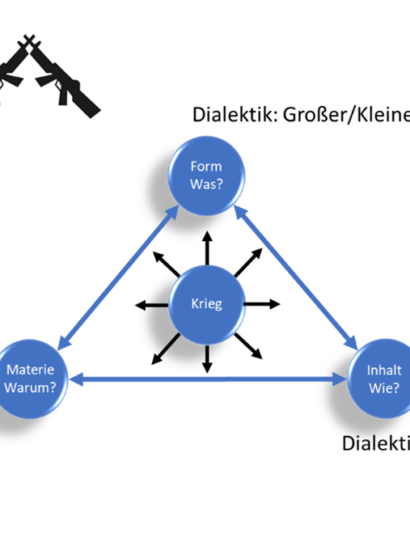

Ein neuer Technikkrieg?

Der Krieg in der Ukraine hat der technikethischen Debatte um künstliche Intelligenz (KI) neue Nahrung gegeben.[1] Aus militärischer Sicht markiert der massenhafte Einsatz von KI (Aufklärung durch Geodatenanalyse, Sprach- und Gesichtserkennung, semiautonome letale Waffen wie beispielsweise loitering munition) einen „Technikkrieg“ von neuer Dimension[2] – allerdings vor allem deshalb, weil zuvor „this relatively new technology has seen few battlefield deployments.“ Tatsächlich wird KI bisher nicht „at scale“ genutzt, sondern „has been limited to certain use cases, tasks, and conditions.“[3] Zwar ist der Krieg in der Ukraine Teil einer sich schon länger vollziehenden „militärtechnologischen Zeitenwende“[4] durch KI, ein sogenannter „Hyperwar“ ist er aber nicht. Auch aus ethischer Sicht hat er – anders, als zuweilen der Eindruck erweckt wird – bisher keine wirklich neuen Argumente gebracht.

Fehlende Regulierungen

Die Debatte um vollautonome letale Waffensysteme (lethal autonomous weapon systems = LAWS) kreist um ein Prinzip, in dem sich zum Beispiel in Deutschland Ethik, Politik und Militär weitgehend einig sind und das auch international Zuspruch findet: dass der Mensch die Letztverantwortung haben muss.[5] Für die zivile Nutzung von KI hat die EU im „AI Act“ am 9.12.23 eine vom zuständigen EU-Kommissar T. Breton als „historisch“ bezeichnete Regelung beschlossen,[6] die sich das gleiche Prinzip zu eigen macht: bei Risikoanwendungen müssen Menschen die Letztkontrolle ausüben. Für autonome Waffen – die „third revolution in warfare“ nach Schießpulver und Atomwaffen[7] – ist eine ähnliche Regulierung derzeit nicht absehbar.

Trotz eines weitreichenden Konsenses unter Ethikern sind Verhandlungen zur Ächtung autonomer Waffen bislang erfolglos geblieben. Immerhin entsprechen die ukrainischen Streitkräfte bisher dem moralischen Grundprinzip: „Ukraine has managed to maintain a human-centric approach toward AI use, with operators making the final decision“.[8] Da aber der Krieg die Entwicklung fortgeschrittener KI wie in einem „living lab“ künftiger Kriegsführung beschleunigt hat,[9] haben Ethiker wie KI-Entwickler Forderungen nach einer international verbindlichen Ächtung von solchen KI-Waffen erneuert, die selbständig Tötungsentscheidungen treffen könnten (LAWS). Vorbild dafür sind Abkommen zu ABC-Waffen oder die Convention on Certain Conventional Weapons.[10]

Trotz eines weitreichenden Konsenses unter Ethikern sind Verhandlungen zur Ächtung autonomer Waffen bislang erfolglos geblieben.

Argumente für und wider KI

In Deutschland hat 2021 der Regierungsbeschluss zur Beschaffung bewaffneter Drohnen eine Debatte zum vorläufigen Abschluss gebracht, deren Argumente auch hinsichtlich KI genutzt werden:[11] Sie verspreche größere Präzision und Wirkung bei gleichzeitiger Reduzierung der Gefahr für die eigene Truppe.[12] Das Schutzargument ist wichtig; zu bedenken ist aber, dass auch die Gegenseite vergleichbare Waffen haben wird. Schon ohne vollautonome Systeme zeigt der Krieg in der Ukraine ein „staggering death toll among soldiers as well as civilians.“[13]

Nachdem im Drohnenkampf zunächst die Kreativität der ukrainischen Streitkräfte überlegen schien, hat sich zuletzt ein Kampf um das elektromagnetische Spektrum entwickelt. Das verstärkt den Ruf nach autonomen Systemen, deren Wirkung nicht durch Störsender beschränkt werden kann. Doch wie jede Technik ist auch KI nicht fehlerfrei. Sie bleibt anfällig, z.B. für Programmierfehler oder Cyberattacken. Deshalb betont die Deutsche Bundeswehr die Relevanz der Auftragstaktik: wenn KI versagt oder durch Hackerangriffe kein Lagebild bereitstellt, muss der militärische Führer handlungsfähig bleiben.[14] Als Argument gegen LAWS wird oft auch die Sorge angeführt, die Verfügbarkeit von KI könne die politische und „psychische Hemmschwelle“ zum Einsatz militärischer Gewalt gerade deshalb reduzieren, weil sie geringere Opferzahlen verspricht.[15] Doch setzt der Gedanke, effektivere Kriegsmittel begünstigten einen ansonsten nicht oder nur schwierig zu rechtfertigenden Krieg, pauschale Zweifel an der Moral politischer Entscheidungsträger voraus.

Wie jede Technik ist auch KI nicht fehlerfrei. Sie bleibt anfällig, z.B. für Programmierfehler oder Cyberattacken.

Die Würde des Menschen ist…

Im Zentrum der Debatte stehen die Menschenwürde und Warnungen vor einer „Entmenschlichung des Kriegs“,[16] und zwar zweifach: erstens dürfen Algorithmus-gesteuerte Maschinen nicht Menschen töten. Letztere würden zu Dingen degradiert, ethisch-rechtliche Grundsätze wie Kants Selbstzweckformel oder das Objektivierungsverbot missachtet. Selbst wenn es gelänge, KI die zweifelsfreie Unterscheidung zwischen Kombattanten und Nichtkombattanten, legitimen und nichtlegitimen Zielen beizubringen, bleibt neben der allgemeinen Fehleranfälligkeit („rogue machines“) die Frage, ob eine auf Feindbekämpfung programmierte Maschine Situationen erkennt, in denen ein militärisches Ziel auch ohne tödliche Gewalt erreicht werden kann.[17] Zweitens hat Menschenwürde eine aktive Seite: sie kommt dem Menschen als intentionsgeleitetes Subjekt moralisch autonomen Handelns zu. W. v. Baudissins Satz, dass Soldaten „als Mensch(en) hinter den Waffen“ stehen,[18] benennt beides: das Gebot, die passive Würde von Soldaten zu schützen, sowie den moralischen Anspruch an Soldaten, denen aufgrund ihrer Verantwortungsfähigkeit die Letztkontrolle beim gerechtfertigten Töten vorbehalten ist.[19]

Moralfähigkeit der KI?

Unstrittig ist die Bedeutung der KI als wesentliches Hilfsmittel auch im Militär. Sollten „eines Tages von KI angetriebene Waffensysteme weitgehend ohne Einsatz von Soldaten einen Krieg entscheiden können, der ethisch vertretbar ist, wäre dies wünschenswert“. Doch auch den Befürworter:innen von KI ist die Gefahr geplanter oder zufälliger Verletzungen der Regeln moralischer und völkerrechtskonformer Kriegsführung bewusst. Aber „dagegen hilft es nicht, die irrige Vorstellung zu mobilisieren, wir könnten KI-Systeme programmieren, die von sich aus moralische Ideen entwickeln, die unseren vielleicht sogar überlegen sind.“[20] Die Bemühungen um eine Regulierung der KI könnten obsolet werden, wenn KI einmal zur moralischen Selbstregulierung fähig sein könnte. Doch was zum Beispiel der führende KI-Forscher R. Arkin „als ethische Pflicht seiner Zunft“ sieht,[21] muss nach M. Gabriel am Wesen der KI scheitern: künstlich erzeugbar sei zwar jene Intelligenz, die in unübertrefflich schneller Datenverarbeitung und Informationsgewinnung (engl. „intelligence“) besteht, nicht aber moralische Intelligenz: „Denn der Problemlösungsraum ethischen Denkens hängt damit zusammen, dass wir verletzliche endliche Lebewesen sind, die sich in andere einfühlen können. Die entsprechenden Vermögen des empathischen Miterlebens mit anderen sind nach heutigem Kenntnisstand nicht modellierbar, weil sie nicht in den Bereich derjenigen Probleme gehören, die sich schnell lösen lassen.“[22]

Der Problemlösungsraum ethischen Denkens hängt damit zusammen, dass wir verletzliche endliche Lebewesen sind, die sich in andere einfühlen können.

Moralische Urteile erfordern einerseits „nicht programmierbare Kontingenzbewältigung“,[23] was Zweifel daran aufwirft, ob KI zur im Vollsinn moralisch reifen Anwendung ethischer Regeln fähig sein kann; andererseits ist fraglich, ob KI-Systeme selbst Moral (weiter) entwickeln können. Sie können „zwar stringenter und kohärenter urteilen als Menschen. Aber sie blockieren genau dadurch auch moralischen Fortschritt im Sinne einer fundamental neuen Einsicht in das moralisch Richtige und Falsche, die damit zusammenhängt, dass wir unsere gesellschaftlich wirksamen Werturteile und Vorurteile verändern. Diese Veränderung unterliegt keinem Algorithmus und keiner allgemeinen Handlungsanweisung“. So gilt es, „KI-Systeme zu optimieren, um im digitalen Wettrüsten nicht unterlegen zu sein, ohne dabei zum Opfer der auch militärisch nicht sinnvollen Illusion zu werden, wir könnten die Soldatinnen und Soldaten der Zukunft durch klügere, effizientere und gar moralisch gerüstete Roboter ersetzen.“[24]

Ethische Bildung stärken

Spricht man mit Soldatinnen und Soldaten der Deutschen Bundeswehr, so sehen auch von ihnen viele aus Sorge vor technischem Rückstand oder der vermuteten Unvermeidlichkeit des Einsatzes autonomer Waffen durch andere Staaten ein Verbot von KI kritisch.[25] Doch eine internationale Regulierung von Risiko-KI entspräche dem Grundgedanken der Inneren Führung und des Humanitären Völkerrechts: weder dem militärischen Sieg noch der Wettbewerbsfähigkeit darf die (eigene) Moral geopfert werden, die sich aus den Werten des Grundgesetzes und damit des Menschenrechtsethos nährt.

Es sei darauf verwiesen, dass neben autonomen Waffen auch andere Anwendungsbereiche der KI verteidigungsrelevante Herausforderungen darstellen, beispielsweise als Mittel der Desinformation. Deren Unmoral definiert sich aus der Verletzung des Wahrheitsgebots. Auch hier hat die EU im zivilen Bereich erste Schritte einer Regulierung vorgenommen, indem sie im „Digital Services Act“ vom 19.10.2022 (in Kraft seit 1.1.2024) Soziale Netzwerke, Plattformen, Suchmaschinen und Online-Händler zur Wahrheitskontrolle verpflichtet.[26] Freilich war die Wahrheit schon immer „das erste Opfer des Krieges“.[27] Russland nützt längst KI-gestützte Propaganda nicht nur zur Manipulation im eigenen Land, sondern versucht, westliche Gesellschaften zu destabilisieren. Der Krieg in der Ukraine hat auch in Deutschland Warnungen vor und Maßnahmen gegen solche Formen hybrider Kriegführung und Cyberattacken verstärkt, an deren Beginn die stete Bewusstmachung der Gefahrenlage steht.[28]

Russland nützt längst KI-gestützte Propaganda nicht nur zur Manipulation im eigenen Land, sondern versucht, westliche Gesellschaften zu destabilisieren.

Die ethische Dimension des Ukraine-Krieges, vor allem das Negativbeispiel des russischen Militärs, das die Regeln moralischer Kriegsführung missachtet, ruft eindringlich die Bedeutung der Ethik für das Militär in Erinnerung; für die Deutsche Bundeswehr belegt sie vor allem die Relevanz der Inneren Führung.[29] Dass nun wieder in Europa Krieg geführt wird, macht nicht nur die Stärkung des Militärs zu kriegstüchtiger Wehrhaftigkeit notwendig, sondern bietet auch eine neue Chance, Soldat:innen wie Gesellschaft die Bedeutung eines moralisch agierenden Militärs zu vermitteln. Dass etwa die Anstrengungen der Bundeswehr zur ethischen Bildung größte Aktualität haben (etwa die geplanten Vorschriften zur ethischen Bildung und zur Persönlichkeitsbildung), zeigt gerade das Thema KI und autonome Waffensysteme – und zwar nicht nur, weil der Umgang damit noch deutlicher Gegenstand ethischer Bildung sein muss, um das Bewusstsein für die hier skizzierten moralischen Fragen zu schärfen, sondern auch, weil KI offensichtlich auf absehbare Zeit die moralische Verantwortung von Soldatinnen und Soldaten nicht ersetzen wird.

Prof. Dr. Dr. Christian Göbel ist Professor für Philosophie an der Assumption University (Worcester, USA) und Oberstleutnant d.R. am Zentrum für Militärgeschichte und Sozialwissenschaften der Bundeswehr (Potsdam) und an der Führungsakademie der Bundeswehr (Hamburg). Forschungsschwerpunkte u.a. in Militärethik und Religionsphilosophie, zahlreiche Publikationen, z.B. Glücksgarant Bundeswehr? (Berlin 2016), Charakter-Haltung-Habitus (Wiesbaden 2022). Bei den in diesem Artikel vertretenen Ansichten handelt es sich um die des Autors. Diese müssen nicht mit jenen der Assumption University bzw. der Bundeswehr übereinstimmen.

[1] Zu weiteren ethisch relevanten Aspekten des Kriegs vgl. Christian Göbel, „Strategie und Moral, Ethische Aspekte des Kriegs in der Ukraine,“ in Jahrbuch Innere Führung 2023/24: Der Krieg in der Ukraine. Folgerungen für die Sicherheits- und Militärpolitik Deutschlands sowie für die Bundeswehr. Hg. Uwe Hartmann, Reinhold Janke, Claus von Rosen (Berlin: Miles, 2024), 167-185.

[2] So der ukrainische Minister für Digitale Transformation, M. Fedorow, bei der Münchner Sicherheitskonferenz 2024, letzter Zugriff März 03, 2024, https://www.linkedin.com/posts/mykhailo-fedorov-9670b4a3_the-most-technologically-advanced-war-in-activity-7163964890511052800-erq5.

[3] Margarita Konaev, Tomorrow’s Technology in Today’s War: The Use of AI and Autonomous Technologies in the War in Ukraine and Implications for Strategic Stability (Washington: CNA, 2023), 1.

[4] Robin Geiß, Die völkerrechtliche Dimension autonomer Waffensysteme (Berlin: Friedrich-Ebert-Stiftung, 2015), 28: https://library.fes.de/pdf-files/id/ipa/11444-20150619.pdf.

[5] Vgl. z.B. die Essays in Norbert Lammert und Wolfgang Koch (Hg.), Bundeswehr der Zukunft. Verantwortung und Künstliche Intelligenz. Berlin: Konrad Adenauer Stiftung, 2023.

[6] So äußerte sich Breton im sozialen Netzwerk X, hier zit. nach https://www.tagesschau.de/ausland/europa/eu-kuenstliche-intelligenz-regulierung-100.html.

[7] Kai-Fu Lee, „The Third Revolution in Warfare,“ The Atlantic, September 11, 2021, https://www.theatlantic.com/technology/archive/2021/09/i-weapons-are-third-revolution-warfare/620013/.

[8] Samuel Bendett, „Roles and Implications of AI in the Russian-Ukrainian Conflict,“ Russia Matters, Juli 20, 2023, https://www.russiamatters.org/analysis/roles-and-implications-ai-russian-ukrainian-conflict.

[9] Robin Fontes, Jorritt Kamminga, „Ukraine: A Living Lab for AI Warfare,“ National Defense Magazine, März 24, 2023, https://www.nationaldefensemagazine.org/articles/2023/3/24/ukraine-a-living-lab-for-ai-warfare.

[10] z.B. Stuart Russell, „AI weapons: Russia’s war in Ukraine shows why the world must enact a ban,“ Nature 614, 23.2.23, 620-623, https://www.nature.com/articles/d41586-023-00511-5. Russell fordert eine Entscheidung der UN-Versammlung, da es dort kein Vetorecht gibt. Umsetzungsmöglichkeiten skizziert Jürgen Altmann, „Zur Beurteilung automatisierter und autonomer Waffensysteme,“ in Handbuch Friedensethik. Hg. Ines-Jaqueline Werkner, Klaus Ebeling (Wiesbaden: Springer 2017), 793-804. Dass aus einer Regulierung kein militärischer Nachteil erwachsen muss, zeigt F. Sauer, „Drei Thesen zur nationalen Regulierung von Autonomie in Waffensystemen,“, in Lammert/Koch, Bundewehr der Zukunft, 59-69.

[11] In der KI-Debatte geht es nur insofern um Drohnen, als sie besonders als Trägersysteme KI-gesteuerter Waffentechnologie geeignet sind; deswegen stellt die Ukraine eine eigene Drohnentruppe auf (Februar 07, 2024). Hier geht es um Kriegsanwendungen im Sinn des Völkerrechts. Daneben könnte KI die Praxis gezielter Tötungen von mutmaßlichen Terroristen im Nichtkriegszustand beeinflussen und die Frage der Vertretbarkeit von Kollateralschäden bei solchen Aktionen, die nur zur unmittelbaren Gefahrenabwehr legal sein können.

[12] In der deutschen Drohnendiskussion führte dies – mit Bezug auf eine Stellungnahme von Militärbischof F.-J. Overbeck – z.B. die Gemeinschaft Katholischer Soldaten an, Februar 24, 2021, https://gemeinschaft-katholischer-soldaten.de/themen/drohnen.

[13] Russell, “AI weapons,” 622. Zudem argumentiert B. Koch, dass moralische Kriegsführung auch die Gegenseite im Blick haben muss und Eigenschutz nicht zulasten ziviler Schäden oder exzessiver Gewalt gegen den Gegner gehen darf, Februar 15, 2020, https://www.katholisch.de/artikel/24322-schutz-oder-eskalation-wie-gerecht-ist-der-weltweite-drohnenkrieg.

[14] Ansgar Rieks, „Digitalisierung der Streitkräfte – ein (nicht nur) technischer Blick,“ in Lammert/Koch, Bundeswehr der Zukunft, 103-118. Rieks sieht KI aber auch als Hilfsmittel und sogar als möglichen Partner des Menschen beim „Führen mit Auftrag“.

[15] In der Diskussion um Drohnen argumentierte so z.B. die „Gemeinsame Erklärung“ der deutschen Bischöfe S. Ackermann (damals Vorsitzender der Deutschen Kommission Justitia et Pax) und F.-J. Overbeck (Katholischer Militärbischof für die Deutsche Bundeswehr) vom 5.2.2013, https://www.bistum-essen.de/fileadmin/bereiche/za-kom/Gemeinsame_Erklaerung_zur_geplanten_Anschaffung_bewaffneter_Drohnen.pdf. Das Zitat stammt hier aus Geiß, Völkerrechtliche Dimension, 13, der eine Bewertung des Arguments im Kontext autonomer Waffen vornimmt. Grundsätzlich wird der Zusammenhang von Opferzahlen, öffentlicher Meinung und Kriegführung seit Langem erforscht. Klassisch ist die – inzwischen kontrovers diskutierte – Studie von John E. Mueller, War, Presidents and Public Opinions (New York: John Wiley, 1973).

[16] Diesen Begriff benutzen u.a. die deutschen Bischöfe F.-J. Overbeck und P. Kohlgraf, vgl. https://www.domradio.de/artikel/bischof-kohlgraf-kritisiert-ki-gestuetzte-waffensysteme (letzter Zugriff März 08, 2024).

[17] Fraglich ist auch, ob die Emotionslosigkeit der KI eine präzisere Einhaltung des Exzessverbots ermöglicht. Kriegsverbrechen aus Hass in der Hitze des Gefechts seien, so Befürworter, damit unmöglich. Unklar bleibt aber, ob das die moralisch positive Wirkung von Empathie aufwiegt. Außerdem werden – auf Dauer unwahrscheinliche – Szenarien vorausgesetzt, in denen Menschen KI gegenüberstehen (Russell, „AI weapons,“ 622).

[18] Wolf Graf von Baudissin, Als Mensch hinter den Waffen. Hg. A. Dörfler-Dierken (Göttingen: Vandenhoeck & Ruprecht, 2006), 118.

[19] Juristisch verbindet sich mit der ungelösten Frage von Verantwortlichkeit und Schuld der KI auch die Frage der Haftung bei Völkerrechtsverletzungen.

[20] Markus Gabriel, „Wert und Mensch in der Ethik der KI,“ in Lammert/Koch, Bundeswehr der Zukunft, 373-383, 377.

[21] Altmann, „Zur Beurteilung,“ 799 bezieht sich auf Ronald Arkin, Governing Lethal Behavior in Autonomous Robots. Boca Raton, Chapman and Hall, 2009.

[22] Markus Gabriel, „Wert und Mensch in der Ethik der KI,“ in Lammert/Koch, Bundeswehr der Zukunft, 373-383, 378. – Auch die emotionale und soziale Intelligenz von Menschen kann bisher nicht adäquat von KI ersetzt werden, obgleich an Trainingsmodellen dafür v.a. in der Wirtschaft zur Optimierung von Kundenkontakten seit Längerem gearbeitet wird (kurzer Überblick z.B. bei https://www.cmswire.com/digital-experience/ai-gets-empathetic-advances-in-emotionally-intelligent-ai/ vom Oktober 03, 2023).

[23] Hartwig von Schubert, „Künstliche Intelligenz – jenseits von Eden. Theologisch-ethische Betrachtungen,“ in Lammert/Koch, Bundeswehr der Zukunft, 403-418, 412.

[24] Markus Gabriel, „Wert und Mensch in der Ethik der KI,“ in Lammert/Koch, Bundeswehr der Zukunft, 373-383, 382.

[25] Der Beitrag ist aus einem Ethik-Seminar des Verfassers an der Führungsakademie der Bundeswehr hevorgegangen.

[26] Vgl. https://digital-strategy.ec.europa.eu/en/policies/digital-services-act-package (letzter Zugriff März 08, 2024).

[27] Der US-Senator H. Johnson (1914) zugeschriebene Satz hat viele Vorläufer. Schon Aischylos äußerte sich ähnlich, erlaubt aber List und Unwahrheit für eine „gerechte Sache“.

[28] Wie dagegen Resilienz zu entwickeln ist, stellen Beiträge des o.g. Jahrbuchs Innere Führung 2023/2024 dar.

[29] Zu den strategischen Konsequenzen einer Kriegsführung, die moralische Normen und die Regeln des Internationalen Völkerrechts missachtet, vgl. Christian Göbel, „Strategie und Moral, Ethische Aspekte des Kriegs in der Ukraine,“ in Jahrbuch Innere Führung 2023/24: Der Krieg in der Ukraine. Folgerungen für die Sicherheits- und Militärpolitik Deutschlands sowie für die Bundeswehr. Hg. Uwe Hartmann, Reinhold Janke, Claus von Rosen (Berlin: Miles, 2024), 167-185.